-

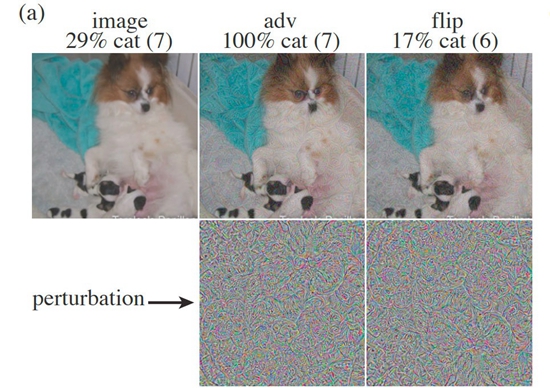

对抗样本案例:一张小狗图片加上不同程度的“扰动”后,被肉眼识别为猫的概率不同。

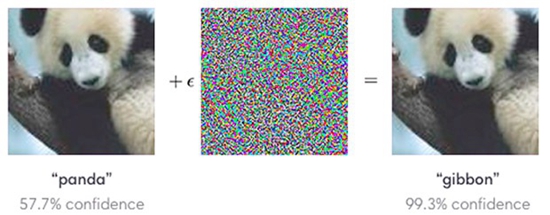

对抗样本案例:加上了“扰动”的熊猫图片被计算机识别为长臂猿。

一辆无人驾驶汽车正在行驶,经过“最高时速60公里”的标志后,它竟忽然提速。车内乘客并不知道,那一刻,无人驾驶汽车把标志看错成“最高时速120公里”。

人工智能没有“近视眼”。如今,计算机“看世界”的能力,在很多领域甚至超过人眼。看似强大的机器有着“阿喀琉斯之踵”。2014年初,当时还在加拿大攻读博士学位的伊恩·古德费洛和同事发现了一个“秘密”。准确率逼近百分百、“看”速飞快的计算机存在着致命的漏洞。

研究者针对“漏洞”精心设计“障眼法”,故意引发计算机错误输出读图结果,这种“障眼法”被命名为对抗样本(adversarial sample)。

想“算计”无人驾驶汽车,只需给原来的交通标志图像加上一层人眼不可见的细微改动。经美国非营利组织OpenAI等机构的研究者证实,这种引发危险的操作能够实现。

人类双眼不太容易犯这种错误。能影响计算机“视觉”的对抗样本不影响人类对同样的视觉对象作出判断。对抗样本可以成为绑在计算机身上的“定时炸弹”。

因提出对抗样本而出名的伊恩·古德费洛,眼下正积极寻求打败对抗样本的办法。只不过在近4年时间里,他还没有获得成功。

“对抗样本”能够被用来操纵人类

伊恩·古德费洛向人类提出了一个问题:当一张蜘蛛的照片摆在你眼前,你确定自己能分清楚那是蜘蛛还是蛇吗?

研究者在蜘蛛的照片上加上“噪声”,就足以迷惑计算机的“眼睛”。只不过这些噪声不是随机生成的,而是一种精心构造的复杂函数。对攻击者而言,要误导计算机把蜘蛛看成蛇,那么它深色的圆形躯干、八只脚、吐出的丝都可以被“加以利用”。

这张图片就被称为对抗样本。通俗地说,这是一种“人眼看着一样但是计算机算法会分类错误”的图像,并且它是被人为构造出来的。

在人眼和大脑的精妙配合下,即便是幼童也很容易区分八只脚的蜘蛛和没有脚的蛇。

不过,古德费洛最新的实验可以对人类稍加打击。他在arXiv最新发布的研究成果显示,人也会将蜘蛛错认为蛇,对抗样本也可能欺骗人类。

参与实验时,受试者会被带到一间光线较暗的房间,面对高清晰度的电脑屏幕,屏幕距离人眼61厘米,按键器摆放在手边。受试者需要对屏幕上的图片作出二选一的抉择——图中事物是猫还是狗、是卷心菜还是西兰花、是蜘蛛还是蛇。

难度来自两方面。首先,受试者不知道自己看到的图像是原始图片还是对抗样本。人类原本无法察觉这些细微扰动,但是古德费洛在对抗样本上加上了视觉“仿生层”。原本清晰的图片叠加了一层带有明显人工痕迹的、令人眼花的纹理,物体的部分边缘、暗部的细节都出现了人眼可见的细微变化。

另一重困难来自时间。当漆黑的屏幕上出现一个“十”字时,受试者就要紧张起来。因为接下来的图片仅会出现60~70毫秒,还不到0.1秒。

稍纵即逝的图片搭配人为干扰——不起眼的变化就能使人眼犯错。即便在准确率最高的“蜘蛛与蛇”组别中,人眼的错判率也接近30%。

“计算机视觉相当于人类视觉的初级处理。”NIPS2017AI 对抗性攻防竞赛(全球首个关于对抗样本的国际性比赛)的冠军组成员庞天宇对中国青年报·中青在线记者表示,这两项对于人类而言稍显苛刻的条件,正是计算机“看”的日常。

在现实世界中,人识别图像用时通常不会如此短暂。有人对古德费洛的最新研究提出质疑,认为将研究对象选为短时间的观察者可能是无意义的。但是在庞天宇看来:“人工智能和传统领域的区别在于,大家(研究者)都不清楚哪个方向才是真正正确的方向,都是不断摸索前进的。如果一篇文章能告诉你应该朝哪个方向研究,这就很有意义。”

对古德费洛团队而言,该研究只是一个开始。他在论文中提示了这样一种风险:“‘对抗样本’能够被用来巧妙地操纵人类。”

计算机会把熊猫看作长臂猿

当计算机应用古德费洛写出的脚本、第一次将猫识别为飞机时,他以为自己写错了代码。

在斯坦福大学的一次公开课上,古德费洛讲道,在目标识别、人脸识别等方面,计算机已经达到了人类水平。在识别照片上的模糊字体时,它的能力比人还强。如果仅看输出结果,面对小小的图形验证码,已经无法区分是人还是机器在作答。

“在2013年以前,计算机犯错是常态而不是例外。算法在大部分情况下效果还不错,对抗样本不会成为一个正经的研究主题。”古德费洛说。不过,随着算法的能力突飞猛进,对抗样本再被摆在研究者眼前时,已是这个领域最热门的话题之一。

“它的产生原因是一个研究热点,说法还比较多。”根据庞天宇的介绍,在人类对图像进行分类时,人会综合颜色、形状、周边环境等多种细节,并根据已有的知识进行判断。人脑的结构非常复杂,并不会像计算机那么机械。而计算机没有真正的眼睛,也没有精妙复杂的大脑。计算机需要把图像的所有信息全部解构成数据,输进模型,给出是与非的答案。当计算机经历过的训练样本还很有限时,就容易出现错误。比如,计算机会把基于熊猫生成的对抗样本看作长臂猿,又会把海龟当成来福枪。

针对计算机视觉的研究由来已久。在上世纪90年代,计算机就能进行手写字符的识别与分类,并在美国的银行中投入使用。不过,真正的大发展是从2012年开始,伴随着卷积神经网络(CNN)的突破和大数据的应用,图像识别才获得了惊人的准确率。

直到一年多以后,同样令研究者感到惊讶的对抗样本被发现。看正常样本准确率近乎完美的计算机,在面对对抗样本时却正确率趋零。

“那时候的人工智能就像在高速公路上飞驰的汽车。所有人都在一门心思研究如何能让汽车跑得更快,但是突然有个人出现说,兄弟,你这样太不安全。”庞天宇说,“对抗样本的出现就像给高速路上的汽车敲响了警钟,提醒它该加装安全带了。”

这还是一个难题。截至目前,提出防御方案的人很多,但是能完全防御对抗样本的模型尚未出现。

“战争”的到来或许只是时间问题

2017年冬天,在古德费洛举办的那场对抗样本攻防大赛中,董胤蓬也是冠军团队的成员。他告诉中国青年报·中青在线记者,团队3人历时两个月才完成了攻击和防守两方面的工作。准备过程中,他们不知道对手会采用何种攻击方式,也不知道为了防范他们的攻击,对手会构筑怎样的堡垒。

与比赛相比,现实世界更难预知。相同的是,“敌人”在暗处。对抗样本只是那柄高悬的“达摩克利斯之剑”闪现的锋芒,对人工智能的恶意攻击宛如一个巨大的黑箱,没人知道“攻击”什么时候到来,来时是什么样。

人们唯一知道的,是他们的算法还不够强健,计算机安全性仍存在明显缺陷。

古德费洛在最新的论文中写道:“一个耐人寻味的现象是,对抗样本通常可以从一个模型迁移到另一个……”攻击者不管知不知道你的算法,都能发起进攻。

研究者证实,物理世界的对抗样本攻击是可行的。最近处于风口上的智能车就是最典型的案例。有学者表示,如果自动驾驶时代来临,街道上的停车、减速等标志被蒙上了对抗样本,可能引发严重的后果。

庞天宇表示:“不管是看X光片还是道路交通标志,这些图形的底层模型都很相似,所以基本都可以受到攻击。”

近来,古德费洛在社交网络中频频转发关于网络安全的文章,并常常进行相关演讲。在谷歌大脑团队对他的介绍中,他的一个重要的研究方向就是互联网隐私与安全。当他找到机器学习中的漏洞后,正在利用自己的影响力,呼吁更多人致力于开发解决方案。他的做法,在牛津大学等机构推出的《人工智能恶意使用报告》中,被称为“高级”对策之一。

技术专家也在使用对抗样本来训练他们的模型,以便让计算机的“目光”变得更加“犀利”,判断更加准确。庞天宇介绍,对抗样本的研究历程“相当于一个相互博弈的过程,一个强的攻击能逼出强的防御,反过来又促进攻击升级”。

【责任编辑:黄易清】 -

相关文章

- 热点新闻更多>>

-

- 闽宁镇的故事

- 习近平为什么在内蒙古参选人大代表?

- 李克强汪洋王沪宁韩正分别参加全国两会一些团组讨论和审议

- 政府工作报告透露哪些改革指向?

- 把祖国北部边疆这道风景线打造得更加亮丽

- 习总书记“下团组”漫评①:激荡多党合作初心

- 习近平谈脱贫摘帽实打实不搞花架子

- 中国的发展有温度 人民的幸福有质感

- 共同书写新时代的发展新答卷

- 习近平画的七个"同心圆"

- 完善政党协商制度决不是搞花架子

- 习近平语重心长表达在内蒙古自治区参加全国人大代表选举的良苦用心

- 国家主席习近平任免驻外大使

- 立“新”除“弊” 习近平纵论新型政党制度

- 李克强总理《政府工作报告》摘要

- 新时代宪法修正案草案展现新亮点

- 习近平:扎实推动经济高质量发展扎实推进脱贫攻坚

- 高质量发展释放民生利好

- 十三届全国人大一次会议在京开幕

- 习近平:扎实推动经济高质量发展扎实推进脱贫攻坚