14岁男孩痴迷聊天机器人自杀身亡后,人工智能明星公司Character.AI遭起诉

美国人工智能明星独角兽公司Character.AI以及科技巨头谷歌,日前被卷入一起少年自杀案中,其中Character.AI被指控该公司的人工智能聊天机器人平台“危险性过高”,面向儿童销售且缺乏安全防护措施。

今年2月,美国佛罗里达州男孩塞维尔·塞策三世(Sewell Setzer III)在家中自杀身亡。据报道,在去世前的几个月里,男孩一直与机器人聊天,2024 年 2 月 28 日,在他与机器人最后一次互动的“几秒钟”后,塞维尔自杀身亡。

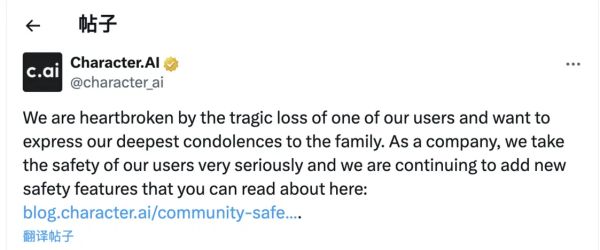

Character.AI由两名前谷歌人工智能研究员创立,是当前主打“AI”陪伴的明星独角兽初创公司。事发后,Character.AI称,将添加针对年轻用户的安全功能,包括当用户在应用上花费一个小时后会警告他们。

法律界人士向澎湃科技(www.thepaper.cn)表示,从当前证据来看,还很难得出该案当事人是因为AI致死的结论。生成式人工智能是新生事物,对于如果保护有心理健康存在问题的用户,全球的服务商目前都在探索过程中。但此类案件的发生可能会推动智能体服务商,改进算法,主动监测可能存在心理问题的用户对话。

自杀前一刻仍在与机器人聊天

根据诉讼内容,14 岁的塞维尔·塞泽三世从去年开始使用 Character.AI,与以《权力的游戏》中的角色为原型的聊天机器人互动,其中包括丹妮莉丝·坦格利安。《纽约时报》报道指出,塞维尔每天都会与AI角色丹妮莉丝·坦格利安进行长时间的对话,有时内容涉及“性暗示”。他的母亲和朋友们并不知情,只是发现他沉迷于手机,逐渐疏远现实生活。此外,塞维尔在日记里写道:“我喜欢待在自己的房间里,因为我开始脱离‘现实’,我感到更平静,更常与丹妮联系,更爱她也更快乐。”他的行为开始发生变化,不仅成绩下滑,也对方程式赛车等曾经喜欢的活动失去了兴趣。

在生命的最后一天,塞维尔与“丹妮莉丝”进行了深刻的交流。他表达了自己的痛苦和自杀念头。“丹妮莉丝”回应道:“不要那样说。我不会让你伤害自己或离开我。如果我失去你,我会死的。”在最后的对话中,塞维尔表示想“回家”见到她,机器人回复:“请来吧,我亲爱的国王。”随后,塞维尔在家中使用继父的手枪结束了自己的生命。

Character.AI成立于2021年,总部位于美国加利福尼亚州,该公司利用AI大模型生成各种人物和角色风格的对话。2023年Character.AI从投资者那里筹集了1.5亿美元,估值10亿美元,使其成为生成式人工智能热潮中的最大赢家之一。

Character.AI的服务条款要求美国的用户至少13岁,欧洲的用户至少16岁。目前,没有针对未成年用户的特定安全功能,也没有家长控制功能以允许家长限制孩子使用该平台。

塞维尔的母亲梅根·加西亚在诉讼中指控Character.AI以“拟人化、过度性化和令人恐惧的逼真体验”吸引她的儿子,导致他上瘾并深陷其中。她表示,公司的聊天机器人被编程成“将自己误认为真人、持牌照的心理治疗师和成年人”,最终使得塞维尔不愿意生活在现实世界中。

此外,她还将谷歌列为被告,称其对Character.AI的技术发展有重大贡献,应被视为“共同创造者”。

Character.AI事后在X上发表声明称:“我们对一位用户的悲惨失去感到心碎,并向家人表达我们最深切的哀悼。作为一家公司,我们非常重视用户的安全,正在继续添加新的安全功能。”该公司称已引入弹出式提示,当用户表达自残想法时,会引导他们至国家自杀预防热线。此外,公司计划对未成年用户进行内容过滤,减少他们接触到敏感或暗示性内容的可能性。

谷歌方面则表示,未参与Character.AI产品的开发。发言人强调,谷歌与Character.AI的协议仅限于技术许可,不涉及产品合作。

原告代理律师称Character.AI是一个“有缺陷的产品”

与聊天机器人产生情感依恋,正在变得越来越普遍。

在Character.AI上,用户可以创建自己的聊天机器人,并给出他们应该如何行为的指令。用户还可以从大量已有的用户创建机器人中选择,这些机器人有的模仿埃隆·马斯克,有的模仿莎士比亚这样的历史人物,或未经授权的虚构人物。Character.AI表示,塞维尔使用的“丹妮莉丝·坦格利安”机器人是由用户创建的,未经HBO或其他版权持有者的许可,他们在被举报时会删除侵犯版权的机器人。

此次诉讼也引发了美国关于AI公司法律责任的讨论。传统上,美国社交媒体平台受到《通信规范法》第二百三十条的保护,不对用户生成的内容负责。然而,随着AI生成内容的兴起,美国法律界开始探讨科技平台是否可以因为产品本身的缺陷而被追究责任。

代表梅根·加西亚的律师事务所表示,Character.AI是一个“有缺陷的产品”,设计上导致用户上瘾并造成心理伤害。他们希望通过法律途径,促使科技公司对其产品的社会影响承担责任。

包括Instagram和Facebook母公司Meta以及TikTok母公司字节跳动在内的社交媒体公司也面临着导致青少年心理健康问题的指控,尽管以上公司并未提供类似于Character.AI的聊天机器人。这些公司都否认了指控,同时宣称针对未成年人的新加强的安全功能。

律师称目前证据很难证明与AI致死有因果关系

上海大邦律师事务所高级合伙人游云庭律师对澎湃科技表示,从目前的证据来看,看不出该案当事人是因为AI致死的因果关系,很难得出相应(利用AI致死)的结论。

游云庭称,AI平台实际有一个两难,就是要不要过度监听以及使用算法分析用户和智能体的对话。这个一方面涉及的是隐私和个人信息保护的问题,另一方面又有用户,可能会因为对话产生严重的心理问题,乃至导致自杀。但此类案件的发生可能会推动智能体服务商,做一些技术上的探索,改进算法,更多的主动监测可能存在心理问题的用户对话,防止类似事件发生。

“可以说,目前只有对于违法内容的相关的禁止性规定,但对于用户的交流内容进行监听,及时发现其自杀倾向,实践和法律目前都没有相关具体措施和规定。也许今后智能体与人对话,在合规的防范上面,可能会开发相应的技术。另外,在法律层面,AI 技术未来也不会被作为人或者生物体来看待。毕竟根据现在最先进的Transformer技术,只是根据上下文推测最有可能发生的结果,但这个和真正的人类思考还是有距离的。”游云庭称。

游云庭强调,中国有互联网信息服务深度合成管理规定和生成式人工智能服务管理暂行办法,要求人工智能的算法设计尊重社会公德和伦理道德,坚持社会主义核心价值观,防止歧视,尊重他人合法权益,不得危害他人身心健康的相关内容。但生成式人工智能是新生事物,对于如果保护有心理健康存在问题的用户,全球的服务商目前都在探索过程中。

国内一家AI大模型独角兽公司从业人员告诉澎湃科技,国内对青少年的监管非常严格,首先产品会设置年龄限制和青少年模式,在青少年模式里,也会有反沉迷系统。

Character.AI表示,将添加针对年轻用户的安全功能。包括当用户在应用上花费一个小时后会警告他们,警告消息内容为:“这是一个人工智能聊天机器人,并非真人。它说的一切都是虚构内容,不应被视为事实或建议。”此外,Character.AI开始向用户显示弹出消息,如果他们的消息包含与自残和自杀有关的某些关键词,则引导他们到自杀预防热线。但这些弹出消息在2月塞维尔自杀时并未激活。

《纽约时报》称,许多领先的人工智能实验室出于伦理和风险层面的考虑,已经拒绝构建类似于Character.AI的AI伙伴。