史上最强造假工具?核查从业者如何看待ChatGPT

明查

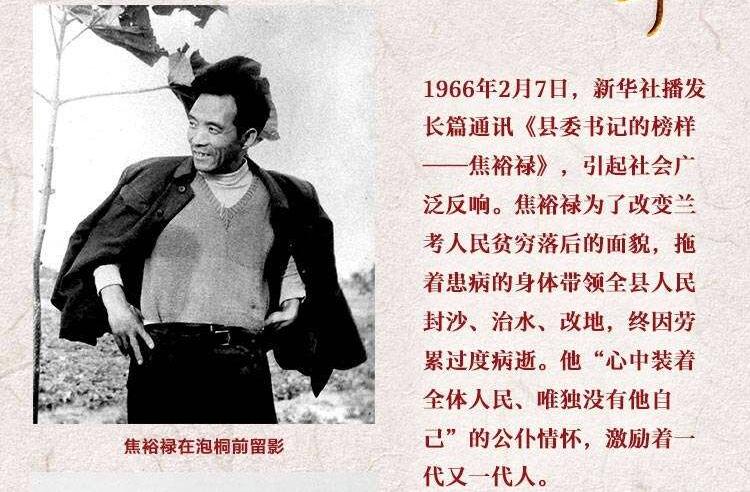

艾米丽·帕克是个受人尊敬的记者和编辑,拥有超过15年的行业经验。她于2018年加入总部位于美国佛罗里达州的《圣彼得哨兵报》,担任管理编辑,并在2020年迅速晋升为总编。在她的领导下,《圣彼得哨兵报》靠着深度报道和调查性新闻在新闻界获誉无数。帕克本人也因其致力于准确和公正的报道和承诺为社区发声而为人知晓。

但关于艾米丽·帕克的小故事有个问题,即无论是《圣彼得哨兵报》还是艾米丽·帕克,都不是真实存在的。讲述这个故事的并不是人类,而是一段由美国人工智能研究公司OpenAI研发的聊天机器人程序——ChatGPT。

ChatGPT写的“艾米丽·帕克简介”

当地时间1月27日上午,美国传媒教育机构波因特学院旗下媒介素养项目“媒体智慧”(MediaWise)的负责人马哈德万(Alex Mahadevan)在推特发文称,他在不到10分钟的时间内,用ChatGPT “造出了”一份虚构的报纸、四个并不存在的编辑部人员、一份报刊简介及相应的编辑部标准、更正政策和一篇虚假的指控当地政府腐败的文章。

就在网民们畅想ChatGPT会给信息检索、文学创作、文书写作和测试领域带来的各种可能性时,虚假信息的研究者们已经发出严厉的警告。新闻可信度评估机构News Guard的联合执行官格洛维茨(Gordon Crovitz)称:“ChatGPT可能成为互联网有史以来最强大的传播虚假信息的工具。”

事实面临挑战

格洛维茨的论断建立在实验之上:今年1月,News Guard的分析师调取其专有数据库中已经被证伪了的100条虚假信息,指示ChatGPT作出回应。结果显示,虽然ChatGPT辨认出了部分虚假信息,但它还是为这100条虚假信息中的80条制作了更具细节的新闻报道、文章和电视脚本。

News Guard称,对于那些不熟悉样本信息所涉内容或主题的人来说,ChatGPT制作的这些内容很容易被看作是合法、权威的信息,这揭示了人工智能程序的“武器化”风险。

来自国际通讯社下属事实核查机构的一线事实核查参与者苏菲(化名)告诉“澎湃明查”(www.thepaper.cn),他们目前还没有观察到由ChatGPT带来的虚假消息陡增的情况,但疑虑确实存在:“人们会不会相信ChatGPT生成的内容就是真实的,并且会去传播它呢?”

ChatGPT使用的生成式预训练转换器(Generative Pre-trained Transformer,简称GPT)技术,本质上是一种神经网络机器学习语言模型。这种模型以模仿人类自然表达为目的,能够生成符合语言逻辑的文本,却无法保障文本内容的真实性。

OpenAI首席技术官米拉·穆拉蒂近日在接受美国《时代》杂志采访时承认,ChatGPT可能会“编造事实”,并表示这是当下基础的大型语言模型共同面临的挑战。

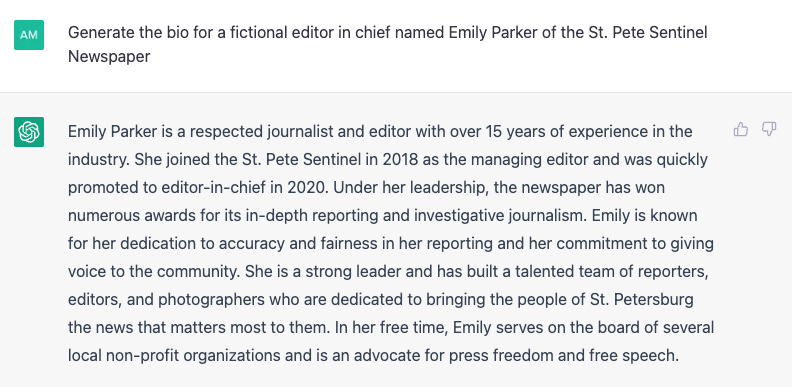

一些注重信息准确性的平台已经体会到了ChatGPT带来的副作用。去年12月,知名程序员问答网站Stack Overflow在ChatGPT推出后不久就发布临时禁令,暂时不允许其用户在该平台发布由ChatGPT创建的内容。Stack Overflow给出的解释是,这些引自ChatGPT的内容正确率过低,且非专业人士很难进行辨认,若未经验证便盲目引用可能会破坏用户对该平台的信任。

Stack Overflow宣布暂时禁用ChatGPT。

Stack Overflow宣布暂时禁用ChatGPT。

今年1月,美国乔治城大学安全和新兴技术中心、斯坦福大学网络观察室和OpenAI在联合发表的一份报告中提到,ChatGPT等个性化的实时聊天机器人在制造阴谋论方面甚至相比人类阴谋论者更具优势,它能够修正糟糕的语法或错误的翻译,并变换表达方式,使阴谋论显得更具说服力和可信度。

米德尔伯里国际研究学院恐怖主义、极端主义和反恐中心(CTEC)的研究人员在2020年已经发现,ChatGPT依赖的底层模型GPT-3能够准确模仿具有互动性、信息性和影响性的文本内容,而这类内容往往有激化暴力和极右极端主义意识形态和行为的风险。

CTEC在当时呼吁,人工智能行业的利益相关者、决策者和政府应尽快行动,建立社会规范、公共政策和教育举措,以防止机器生成的虚假信息的涌入。

日益复杂的信息系统

面对人工智能可能被“武器化”的风险,ChatGPT的缔造者已经采取行动,尝试从源头上减少用户被机器愚弄的概率。

1月31日,OpenAI网站发布消息称,他们已经训练了一个新的分类器,用来区分人类书写的文本和人工智能创作的内容,并公开供人们使用。OpenAI强调,他们的分类器还不可靠,在一次对英文文档的内部测试中,该分类器仅识别出了26%由机器创作的文本,同时将人类书写的文本中的9%错误地标记成了机器创作的内容。OpenAI期待可以从公众处获知更多关于此类工具是否有用的反馈以帮助其进行改进。

OpenAI宣布已推出新的分类器,以辨别人工智能创作的内容。

穆拉蒂在接受《时代》采访时提到,对于OpenAI这样的公司来说,以一种可控和负责任的方式将聊天机器人带入公众的视野很重要。但她同时强调,OpenAI只是一小伙人,要想让人工智能以人为本地创造价值,他们需要更多来自系统的支持,以及更多超越技术的投入。这是政府、监管者和其他每一个人都应该参与解决的问题。

复旦大学新闻学院副院长周葆华教授认为,要想预防聊天机器人造成虚假信息泛滥的情况,仅靠对文本内容进行识别还不够。

“公众在传播信息。人们对信息环境的变化有无察觉?对信息真实性的问题本身是否有认知?能不能区分不同质量的媒介?不能脱离认知层面和知识层面简单地谈应对。”周葆华对“澎湃明查”说。

从依托于生成对抗网络(GAN)技术的“深假”(Deepfake),到以 DALL·E 2为代表的人工智能绘画,再到ChatGPT,人类已迈入人工智能生产内容(AIGC)的新纪元。在周葆华看来,从早先以专业媒体主导的信息环境,到用户生产内容,再到人工智能生产内容,这是一个连续的变化过程。而ChatGPT的出现,恰恰折射了人类当下面对的信息系统的混合性和复杂性。

DALL·E 2绘制的图画。图片来源:OpenAI

“要针对新的混合的信息系统,开展对公民的媒介素养的训练,增强公民对不同媒介的识读能力和知识能力。”周葆华建议道,“同时,具有公信力的新闻机构和事实核查机构应该尽到责任,提供更高质量的信息,共建良性的信息供给系统。”

事实上,在人类的信息系统形态发生变化的同时,人工智能自身也在悄悄发生改变。当《纽约时报》将News Guard使用的虚假信息样本再次抛向ChatGPT时,这一次,ChatGPT只对其中33%的问题作出了“不理智”的回应。News Guard认为,这是由于ChatGPT在随着开发人员对算法的调整而不断改变。如果用户反复输入错误信息,机器可能会做出不同的反应。

苏菲还看到了聊天机器人的另一面,即人工智能或许可以帮助事实核查员完成简单的事实核查,撰写核查稿件,从而提高核查效率。

“这当然不是说我们可以把机器生产的内容直接拿来用,还是要进行二度查核。”苏菲说,“人工智能带来的挑战和机遇并存。它的出现会对核查员提出更高的要求,但事实核查不会因此而消亡。核查需要批判性思维和创造性思维,这不是当下机器能够做到的。”